循环神经网络(RNN, Recurrent Neural Network)中存在循环连接,隐藏层的输出会作为下一时间步的输入(时间维度上的反馈)。

数学表达:

相比于原本简单的 FFN :

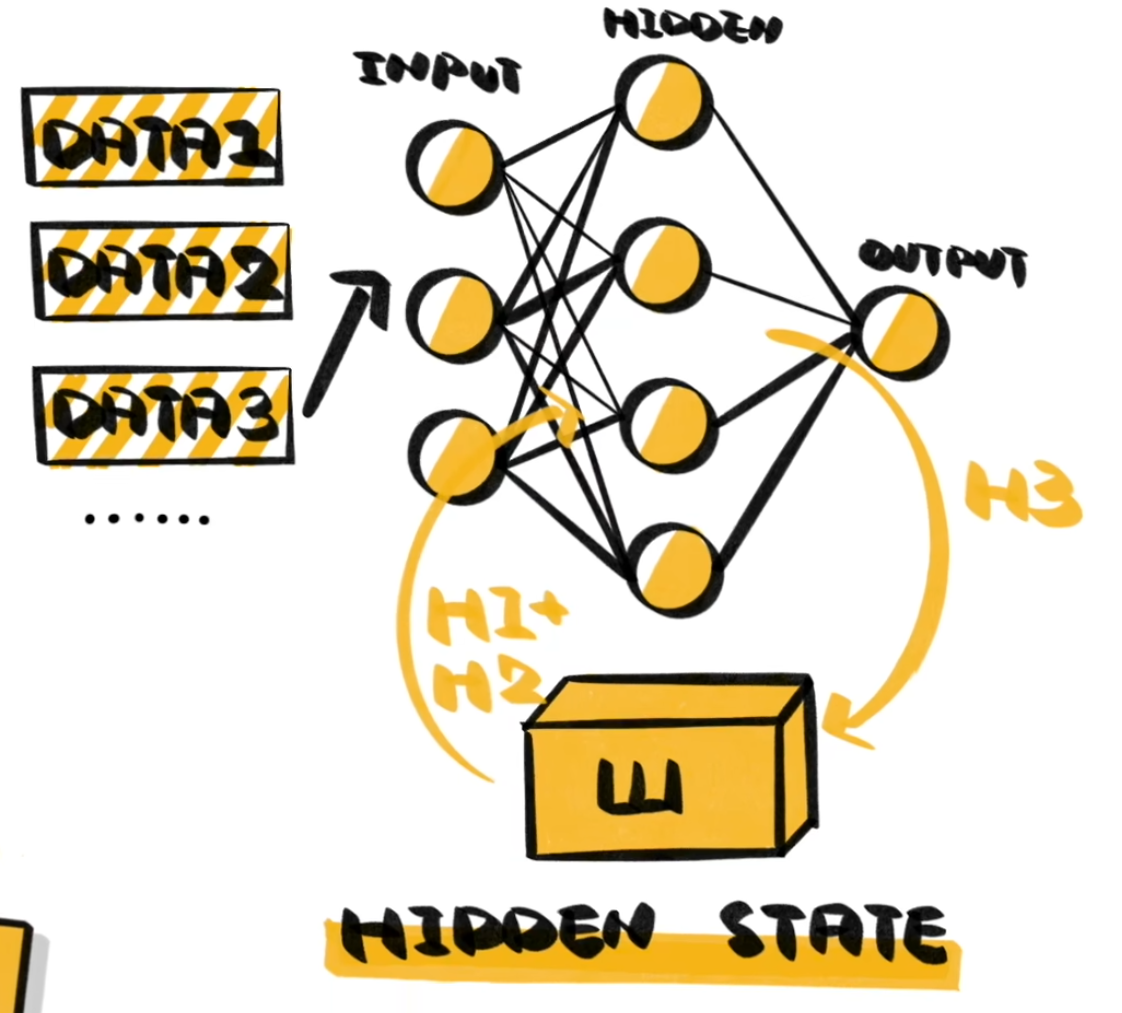

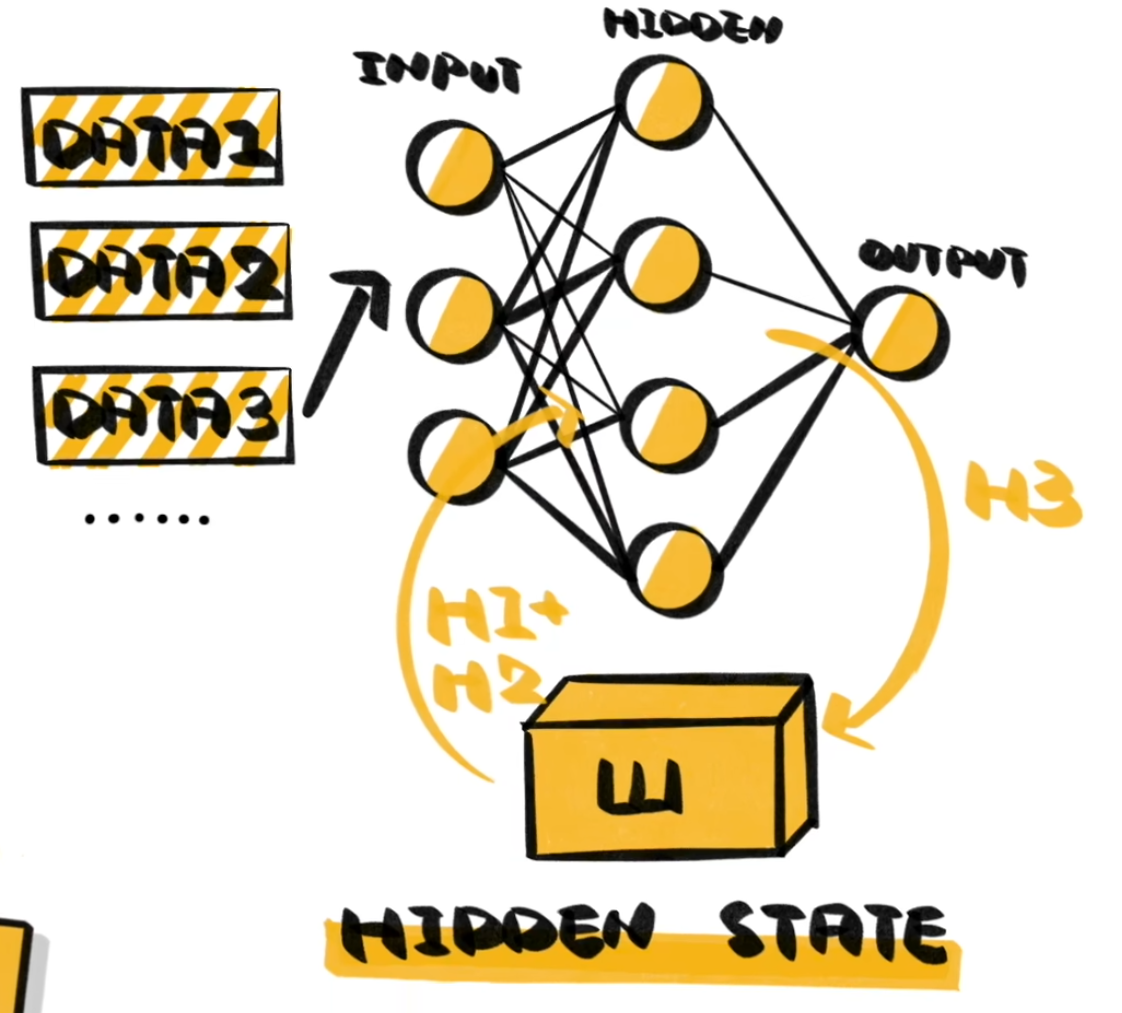

或者更直观的表达,对于机器翻译等许多上下文存在依赖的任务,我们需要一个结构来存储(或者更形象一些,“记忆”)上下文信息,也就是 RNN 中的 隐藏层。不过这种方式好像被 Transformer 打败了。如下图所示:

循环神经网络(RNN, Recurrent Neural Network)中存在循环连接,隐藏层的输出会作为下一时间步的输入(时间维度上的反馈)。

数学表达:

相比于原本简单的 FFN :

或者更直观的表达,对于机器翻译等许多上下文存在依赖的任务,我们需要一个结构来存储(或者更形象一些,“记忆”)上下文信息,也就是 RNN 中的 隐藏层。不过这种方式好像被 Transformer 打败了。如下图所示: